WindowsにLatentSyncで大苦戦!AIリップシンクをローカルPCで動かそうとしてエラーの地獄を見た全記録

「ローカルPCで手軽にAIリップシンクを楽しみたい!」そんな甘い夢を見て、巷で話題の「LatentSync」をインストールしようとしたのが全ての始まりでした。まさか、これが数々のエラーという名の強敵と戦い、黒い画面(ターミナル)という名のダンジョンを彷徨う、壮大な冒険になるとは…この記事は、その血と汗と涙の全記録です。

第一章:冒険の始まり - Git Cloneと最初の洗礼

まずは基本から。GitHubからプロジェクトをダウンロード(クローン)します。ここまでは順調でした。

git clone https://github.com/bytedance/LatentSync.git

cd LatentSync

そして、説明書(README)通りにセットアップスクリプトを実行!…しようとしたら、Windowsは冷たく言い放ちます。

source setup_env.sh

実行結果 → source: command not found

そう、これはLinux用のコマンド。Windowsでは動かない。ここから、私の長い戦いが始まったのです。

第二章:救世主WSL2 - 新たな大地と「何も無い」現実

賢者(ネットの有識者)は言いました。「WSL2を使いなさい」と。Windows上でLinuxを動かす魔法の言葉です。

# PowerShellを管理者で開き、WSLをインストール

wsl --install

Ubuntuが起動した時は感動しました。しかし、そこはまっさらな大地。当然、Python環境を管理するCondaなど入っていません。

実行結果 → conda: command not found

解決策は、この新しい大地にCondaの種を蒔くことでした。

# Minicondaのインストーラーをダウンロード

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# インストールを実行(対話形式で yes を押していく)

bash Miniconda3-latest-Linux-x86_64.sh

# ターミナルを再起動! これが超重要!

第三章:無限コンパイルエラー - g++よ、お前はどこにいる

Condaの準備も整い、今度こそライブラリをインストール!

# LatentSync用の環境を作り、有効化

conda create -n latentsync python=3.10 -y

conda activate latentsync

# いざ、インストール!

pip install -r requirements.txt

しかし、新たな壁が立ちはだかります。

実行結果 → error: command 'g++' failed: No such file or directory

insightfaceというライブラリのビルドに必要なC++コンパイラ(プログラムの翻訳機)が入っていなかったのです。これもLinuxの初期設定あるある。大工道具一式をインストールします。

# 必要なビルドツール一式をインストール

sudo apt update

sudo apt install build-essential

これを実行後、再度pip installを試み、ついにライブラリのインストールが完了しました。

第四章:改行コードの罠 - WindowsとLinux、見えざる壁

ライブラリも入り、満を持してセットアップスクリプトを再実行!しかし、無情にもエラーが。

実行結果 → No such file or directory: 'requirements.txt\r'

犯人は、WindowsとLinuxの改行コードの違い。\rという見えない文字が悪さをしていました。これをLinux形式に変換する魔法のコマンドがdos2unixです。

# 変換ツールをインストール

sudo apt install dos2unix

# スクリプトファイルをLinux形式に変換

dos2unix setup_env.sh

第五章:モデルファイルとの死闘 - 破損したデータEOFError

数々の死闘を乗り越え、ついにアプリが起動! Running on local URL... の文字に涙が出ました。

しかし、動画を生成しようとすると、またエラー。

実行結果 → Model checkpoints/whisper/tiny.pt not found

音声認識モデルが無い。これもスクリプトがやってくれるはずだった作業。手動でダウンロードします。

# フォルダを作り、モデルをダウンロード

mkdir -p checkpoints/whisper

wget -O checkpoints/whisper/tiny.pt https://openaipublic.azureedge.net/main/whisper/models/65147644a518d12f04e32d6f3b26facc3f8dd49e5d9baa7c52343d9b24ba2902/tiny.pt

しかし、次に待っていたのはダウンロードファイルの破損。

実行結果 → EOFError

ダウンロードが不完全だったようです。壊れたファイルを削除し、再ダウンロード&サイズ確認で乗り越えました。

# 壊れたファイルを削除

rm checkpoints/whisper/tiny.pt

# 再ダウンロード

wget -O checkpoints/whisper/tiny.pt https://...(上記URL).../tiny.pt

# ファイルサイズを確認!「74M」くらいあればOK!

ls -lh checkpoints/whisper/

最六章:灯台下暗し - Hugging Faceに全てがあった

心が折れかけたその時、天啓が。なんと、Hugging Faceに最新版のLatentSyncが全モデルファイル付きで公開されていたのです。

結論:最初からこれをやれば良かった。

これが、エラーの地獄から生還するための、最も確実で、最も簡単な手順です。

Hugging Faceからlatentsync_unet.ptをダウンロードしてcheckpointsフォルダに配置します。

そして/whisper/tiny.ptをダウンロードしてcheckpoints/whisperフォルダに配置します。

checkpoints/

├── latentsync_unet.pt

└── whisper/

└── tiny.pt

そしてついに、私のローカルPCでAIが喋り出したのです。長かった…本当に長かった!

!しかし非力な私のPCではなかなか動画が生成できないません...

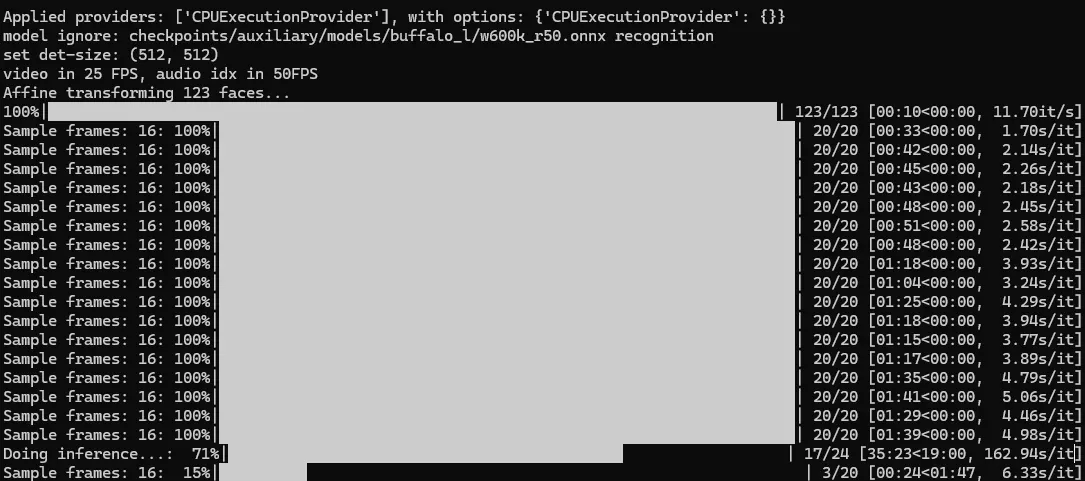

このようなエラーがでてたのに動いてるので、まあいいかと思い、そのまま動かしていましたらなんと!CPUで動いていたのです。😢

Applied providers: ['CPUExecutionProvider'], with options: {'CPUExecutionProvider': {}}

model ignore: checkpoints/auxiliary/models/buffalo_l/genderage.onnx genderage

2025-08-23 20:41:21.039152396 [E:onnxruntime:Default, provider_bridge_ort.cc:2036 TryGetProviderInfo_CUDA] /onnxruntime_src/onnxruntime/core/session/provider_bridge_ort.cc:1695 onnxruntime::Provider& onnxruntime::ProviderLibrary::Get() [ONNXRuntimeError] : 1 : FAIL : Failed to load library libonnxruntime_providers_cuda.so with error: libnvrtc.so.12: cannot open shared object file: No such file or directory

私のPCに搭載された高性能な**GPU(グラフィックボード)**は完全に無視され、汎用的なCPUが必死に計算していたのです。スーパーカーがあるのに、軽自動車でレースに出ていたようなもの。ここから、本当の最終決戦が始まりました。

第七章:真の黒幕 - ONNXとCUDA Toolkitを巡る最終決戦

GPUを動かすため、GPU版のPyTorchをインストールし直すも、状況は変わらず。ログの奥底に、真の黒幕からのメッセージが記されていました。

FAIL : ... libnvrtc.so.12: cannot open shared object file: No such file or directory

犯人はPyTorchではなく、insightfaceが使う別のライブラリONNX Runtimeでした。彼がGPUを使うには、NVIDIAが提供する**「CUDA Toolkit」という完全な開発キット**が必要だったのです。

これが、この長い戦いを終わらせるための最後の儀式でした。

Bash

=== NVIDIA CUDA Toolkit インストール全手順 ===

1. 必要なパッケージとリポジトリキーを準備

sudo apt-get update

sudo apt-get install -y gpg

wget https://developer.download.nvidia.com/compute/cuda/repos/wsl-ubuntu/x86_64/cuda-wsl-ubuntu.pin

sudo mv cuda-wsl-ubuntu.pin /etc/apt/preferences.d/cuda-repository-pin-600

2. CUDAリポジトリ本体をダウンロード (2.7GBもある巨大ファイル!)

wget https://developer.download.nvidia.com/compute/cuda/12.5.1/local_installers/cuda-repo-wsl-ubuntu-12-5-local_12.5.1-1_amd64.deb

sudo dpkg -i cuda-repo-wsl-ubuntu-12-5-local_12.5.1-1_amd64.deb

sudo cp /var/cuda-repo-wsl-ubuntu-12-5-local/cuda-*-keyring.gpg /usr/share/keyrings/

sudo apt-get update

3. CUDA Toolkit 本体をインストール!

sudo apt-get -y install cuda-toolkit-12-5

4. プログラムがToolkitを見つけられるようにパスを設定(超重要)

echo 'export PATH=/usr/local/cuda-12.5/bin${PATH:+:${PATH}}' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda-12.5/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}' >> ~/.bashrc

5. 設定をターミナルに再読み込みさせる

source ~/.bashrc

この長い呪文を唱え終わり、ターミナルを再起動。祈るような気持ちでアプリを起動すると…

Applied providers: ['CUDAExecutionProvider']

ついに、ついにスーパーカーのエンジンがかかったのです!処理速度は爆発的に向上し、数十分かかっていた処理がわずか数分で終わるようになりました。

最終的な起動方法!

cd /mnt/c/Users/あなたのホームディレクトリ/

cd LatentSync

conda activate latentsync

python gradio_app.py

約15秒の動画を生成するのに1:12:43かかりました...

私のスペック

NVIDIA GeForce RTX 3060 VRAM12GB

この記事がいいと思ったら、私に高スペックのPCプレゼントしてください!

教訓:諦めなければ、GPUは動く 今回の冒険で学んだことは、

ローカルPCでのAI環境構築は、エラーの「もぐら叩き」

CPUExecutionProviderの文字を見たら、GPUが動いていない証拠

PyTorchだけでなく、ONNXなど他のライブラリの依存関係も疑うべし

何があっても諦めない心が、GPUを動かす

まとめ

ローカルでのAI環境構築は、エラーとの戦いです。しかし、一つ一つのエラーには必ず原因と解決策があります。この記事が、同じようにダンジョンを彷徨う未来の冒険者のための「攻略本」となれば幸いです。